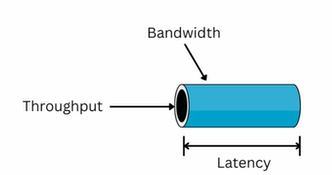

강의 데이터 처리 단계 데이터 수집 (Collection) 데이터 저장 (Storage) 데이터 처리 (Processing) 데이터 저장 시스템 변천 1980년대 후반 : Data Warehouse 2000년대 후반 : Data Lake 2010년대 중반 : Cloud Data Platform / Messaging Queue 2021년 : Data Mesh SLA "SLA"(Service Level Agreement)는 서비스 제공업체와 고객 간의 계약 혹은 합의 입니다. 서비스 품질, 성능 및 가용성의 합의된 수준을 개괄적으로 기술 통신, 클라우드 컴퓨팅에서 사용 사내 시스템 간에도 가능 성능 처리량(Throughput) : 단위 시간 동안 처리할 수 있는 데이터의 양 지연시간(Latency) : 데이..